L'Union européenne a atteint vendredi soir, après trois jours de négociations entre les États membres et le Parlement européen, un accord sur une législation pour réglementer l'intelligence artificielle (IA). "L'Acte d'IA de l'UE est le premier cadre juridique complet pour l'intelligence artificielle au monde. C'est donc un moment historique", a déclaré samedi la présidente de la Commission européenne, Ursula von der Leyen, accueillant l'accord.

C'est le commissaire européen au Marché intérieur, Thierry Breton, qui a annoncé sur X (anciennement Twitter) que l'accord avait été atteint. Lui et la vice-présidente de la Commission européenne, Vera Jourova, ont veillé à ce que les négociateurs du Conseil (les États membres) et du Parlement respectent l'esprit de leur proposition.

Avec la loi sur l'IA, l'Europe vise à respecter la sécurité et les droits fondamentaux de ses citoyens, tout en préservant et stimulant le caractère innovant et la compétitivité du secteur européen de l'IA. En étant la première à proposer une telle législation, elle vise à établir une norme internationale.

Un classement selon les risques de l'IA

Le principe de base est que les systèmes d'IA seront classés selon leur profil de risque. La plupart des applications d'IA tomberont dans la catégorie "risque minimal" et ne devront donc pas se conformer à des obligations spécifiques. Il s'agit, par exemple, de filtres anti-spam ou de systèmes de recommandation qui font des suggestions aux utilisateurs sur la base d'un algorithme (comme des playlists personnalisées ou des aperçus de produits dans les boutiques en ligne).

La situation est différente pour l'IA à "haut risque".

Pas n'importe quelle données

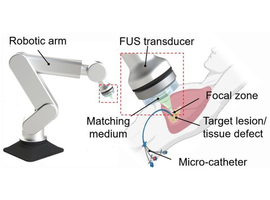

Étant donné que l'intelligence artificielle est intrinsèquement liée à de grandes bases de données, ces systèmes ne pourront pas collecter n'importe quelle donnée et devront réduire leur risque inhérent autant que possible. Chaque activité devra être documentée, les utilisateurs devront savoir à quoi s'attendre et une surveillance humaine devra être assurée en tout temps.Cela peut sembler abstrait, mais des exemples tels que les applications d'IA dans les infrastructures énergétiques, les applications médicales, les systèmes pour déterminer l'accès aux établissements d'enseignement ou les profils professionnels, ou les applications utilisées dans le maintien de l'ordre, illustrent clairement de quoi il s'agit. L'identification biométrique et les applications qui reconnaissent automatiquement les émotions sont par définition classées comme à haut risque.

Des exceptions pour l'identification biométrique

Au cours des négociations, il y a eu beaucoup de discussions sur les applications d'IA présentant un "risque inacceptable" et qui doivent donc être interdites. Par exemple, le Parlement européen a insisté sur une interdiction totale de l'identification biométrique. Néanmoins, les États membres ont réussi à obtenir certaines exceptions. Ainsi, la reconnaissance faciale en temps réel ne sera autorisée que dans la recherche de victimes, par exemple, d'enlèvements ou de traite des êtres humains, ou pour prévenir une menace claire comme une attaque terroriste. Les suspects dans de telles affaires pourront également être identifiés par biométrie, mais un accord préalable d'un juge d'instruction sera nécessaire.

Interdiction totale du "social scoring"

Les applications pour lesquelles aucune exception n'a été convenue et qui seront donc toujours interdites comprennent le "social scoring" tel qu'il existe en Chine, la collecte aléatoire d'images de visages pour créer des bases de données, et la catégorisation des personnes sur la base de leurs convictions politiques, religieuses ou philosophiques, de leur orientation sexuelle ou de leur race. La reconnaissance des émotions sur le lieu de travail ou dans l'éducation est également interdite.

Des obligations supplémentaires pour l'IA générative

Les exigences de transparence constituent un autre point d'attention particulier de la nouvelle législation. Toute personne utilisant un système d'IA, comme un chatbot, devra être clairement informée qu'elle communique avec une machine. Les deepfakes et autres contenus générés par l'IA doivent toujours être étiquetés comme tels.

Ces derniers mois, les avancées majeures en matière d'IA générative, capable de créer elle-même des textes, des images et d'autres contenus, tels que ChatGPT, DALL-E et Bard, ont attiré l'attention. Ces "modèles de base" seront soumis à des obligations supplémentaires de transparence. Ils devront se conformer à la réglementation européenne en matière de droits d'auteur et être accompagnés de résumés détaillés du contenu utilisé pour entraîner les modèles. Des obligations supplémentaires seront imposées pour l'IA générative qui pourrait comporter des risques systémiques.

Un bureau de l'IA à la Commission européenne

Pour superviser ces modèles avancés d'IA, un "Bureau de l'IA" sera établi au sein de la Commission européenne. Ce sera le premier organe au monde capable d'imposer des règles contraignantes en matière d'IA et deviendra probablement une référence internationale, selon la Commission.

Pour stimuler l'innovation dans le secteur européen de l'IA, les petites entreprises d'IA pourront développer leurs applications dans des environnements protégés, afin de ne pas être écrasées par de grands acteurs internationaux. "La loi sur l'IA est un tremplin pour les startups européennes et les chercheurs, leur permettant de prendre la tête de la course vers une IA fiable", a déclaré le commissaire Breton.

Enfin, il a été convenu que les entreprises qui ne respectent pas les règles européennes de l'IA risqueront des amendes pouvant aller de 7,5 millions d'euros ou 1,5 % de leur chiffre d'affaires mondial à 35 millions d'euros ou 7 % de leur chiffre d'affaires, en fonction de la nature de l'infraction et de la taille de l'entreprise.

Entrée en vigueur en 2026

La nouvelle loi sur l'IA doit encore être formellement adoptée par le Conseil et le Parlement européen en séance plénière. Elle devrait entrer en vigueur en 2026. En attendant, l'UE travaille sur un Pacte d'IA, permettant aux entreprises de s'engager à appliquer volontairement certaines obligations de la législation. Selon la présidente de la Commission, Ursula von der Leyen, environ 100 entreprises ont déjà manifesté leur intérêt pour ce Pacte.

La loi est conçue pour être technologiquement neutre, ce qui signifie que les systèmes d'IA futurs, encore inconnus aujourd'hui, seront automatiquement couverts par son champ d'application.